Startseite » Blog » Google Quality Updates – Was ist los? Was können Betroffene tun?

Das Jahr 2017 glich für viele Webseitenbetreiber einer Achterbahnfahrt: Seit dem Frühjahr hat eine Reihe von Google Updates zu starken Fluktuationen in den SERPs und beim organischen Traffic gesorgt.

Während sich SEOs in den letzten Jahren an eine Update-Frequenz von circa 6 Monaten gewöhnt hatten, kommen die Algorithmusänderungen in diesem Jahr fast im Monatstakt, seit Herbst sogar noch häufiger.

An dieser Stelle muss darauf hingewiesen werden, dass Google seinen Rankingalgorithmus mehrmals täglich verändert, wobei die meisten Updates nur kleine Auswirkungen haben und in der Regel nur von wenigen Menschen bemerkt werden.

Das ist bei den hier angesprochenen Quality Updates nicht der Fall: Eine große Anzahl von Webseiten weltweit ist von starken Rankingveränderungen und Sichtbarkeitsverlusten oder –gewinnen betroffen. Oft können sich die Seitenbetreiber nicht erklären, was die Gründe für diese Entwicklungen sind.

In dieser Situation wollen wir durch den vorliegenden Beitrag versuchen, etwas Licht ins Dunkel zu bringen, die aktuelle Entwicklung zu erklären und Ratschläge zu geben, was Webmaster tun können, um sich von den Auswirkungen der Updates zu erholen oder diesen proaktiv vorzubeugen.

Dazu soll zunächst ein kurzer Abriss über die wichtigsten Updates der Vergangenheit gegeben werden. Anschließend werden wir mögliche Ziele und Ursachen der aktuellen Veränderungen untersuchen und abschließend Handlungsempfehlungen für betroffene oder besorgte Webmaster anführen.

Seit es Google gibt, gibt es auch Google Algorithmus Updates. Während die meisten dieser Veränderungen größtenteils unbemerkt über die Bühne gehen, gab es in der Vergangenheit einige Updates mit starken Auswirkungen, die teilweise sogar über die SEO-Szene hinaus für Aufregung sorgten.

Für große Algorithmus-Updates gibt es eine Vielzahl verschiedener Gründe, der wohl wichtigste ist für Google die Bekämpfung von Spam. Hierunter versteht Google jeden Versuch, die Rankings einer Seite durch Methoden zu beeinflussen, die gegen ihre Richtlinien für Webmaster verstoßen.

Hierzu gehören zum Beispiel manipulative Techniken des Linkaufbaus, Keyword-Stuffing, Cloaking oder das Kopieren von Inhalten anderer Webseiten, um hierdurch Rankings zu stehlen. All diese Techniken widersprechen dem Ziel jeder Suchmaschine, ihren Nutzern nach Möglichkeit die für ihre Suchanfragen relevantesten und besten Ergebnisse auszuliefern.

Wir werden hier kurz die wichtigsten Updates vorstellen, um die aktuellen Veränderungen besser einordnen zu können. Einen genauen Überblick über alle bekannten Google Updates liefert folgende Aufstellung bei moz.com.

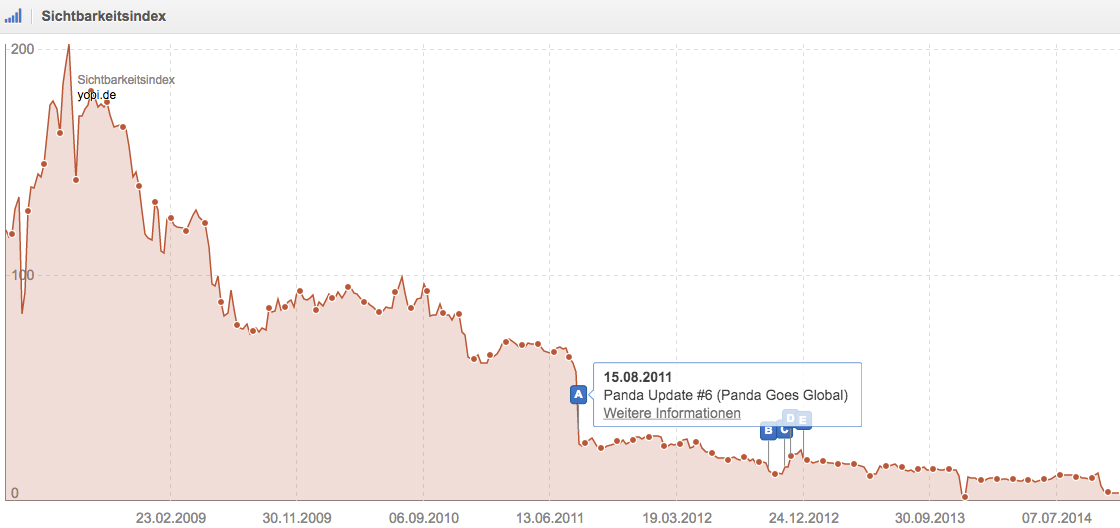

Das Ziel der Panda Updates war die Bekämpfung von Seiten mit Inhalten ohne Mehrwert, die lediglich erstellt wurden, um für spezifische Keywords oder Kombinationen zu ranken. Das erste Panda-Update wurde im Februar 2011 zunächst in den USA und in den Folgemonaten weltweit ausgerollt. Es hatte massive Auswirkungen auf die Rankings vieler Seiten und betraf laut Google rund 12% aller Suchanfragen.

Abbildung 1: Beispiel für ein Panda-Opfer. Quelle: SISTRIX

Der Panda-Algorithmus wurde im selben Jahr noch mehrfach angepasst, mit größeren Änderungen im April, August und Oktober.

In den folgenden Jahren kam es zu einer Vielzahl von weiteren Panda-Updates, bis der Algorithmus Anfang 2016 in den sogenannten Core Ranking Algorithm integriert wurde und seitdem in Echtzeit läuft.

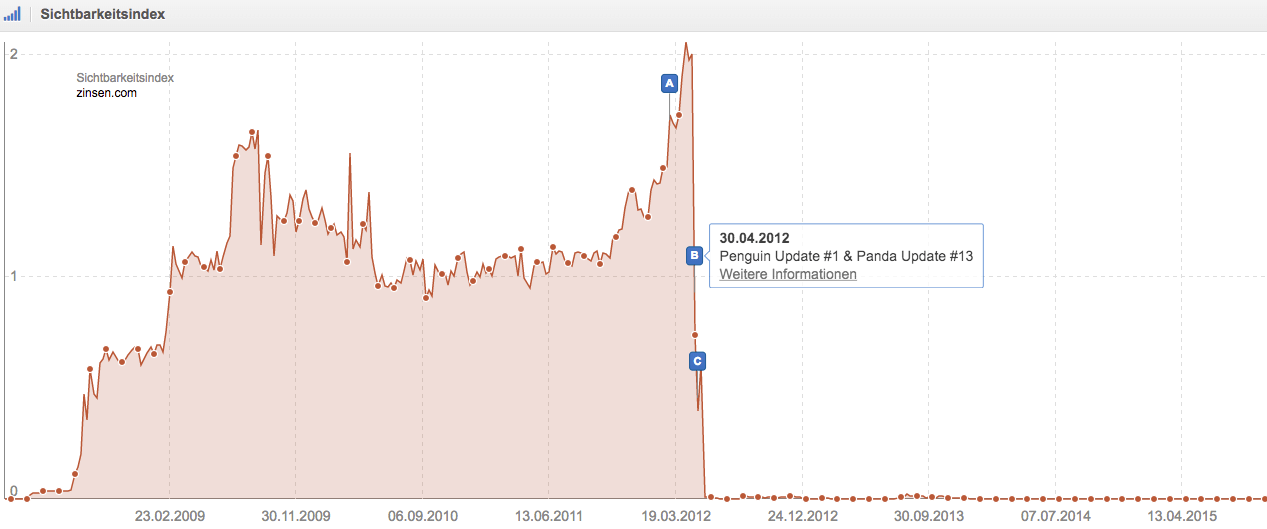

Das Hauptziel der Penguin Updates war die Bekämpfung von Linkspam. Hierunter wird der manipulative Aufbau von externen Verlinkungen mit dem Ziel einer Rankingverbesserung verstanden. Techniken des Linkspams umfassen unter anderem Linktausch, Private Blog Networks, Linkkauf und das Einfügen von Links auf gehackten Webseiten.

Das erste Penguin Update wurde im April 2012 ausgerollt und sorgte wie die Panda Updates für große Fluktuationen in den SERPs. Webseiten, die auf das – bis dahin sehr erfolgreiche – manipulative Linkbuilding gesetzt hatten, verloren teilweise über 90% ihrer Sichtbarkeit:

Abbildung 2: Beispiel für ein Penguin-Opfer. Quelle: SISTRIX

Auch der Penguin Algorithmus wurde in den Folgejahren mehrfach geupdated, wobei diese Updates von betroffenen Webmastern sehnlichst herbeigewünscht wurden, da sie die einzige Möglichkeit darstellten, einmal verlorene Sichtbarkeit zurückzugewinnen.

Mit dem letzten großen Penguin Update (Penguin 4.0) von Ende 2016 wurde Penguin in den Core Algorithmus integriert und läuft jetzt ebenfalls in Echtzeit.

Hierbei handelt es sich um eine Reihe von Änderungen an Googles Kernalgorithmus. Diesen Updates liegen darüber hinaus keine verbindenden Ziele zugrunde außer einer allgemeinen Verbesserung der ausgespielten Suchergebnisse.

Die wichtigsten Core Algorithm Updates waren:

Unter den Phantom Updates wird eine Reihe von Algorithmusänderungen verstanden, die niemals von Google bestätigt wurden und deren technische Grundlagen nicht klar erkennbar waren.

Dies spiegelt auch sehr gut den Wandel in der Kommunikation von Google bezüglich ihrer Updates wider: Während bis circa 2013 eine Vielzahl von Updates sehr genau erklärt und teilweise auch im Vorfeld angekündigt wurden, hüllt sich Google seitdem in der Regel in Schweigen.

Insgesamt werden fünf Updates als Phantom Updates bezeichnet:

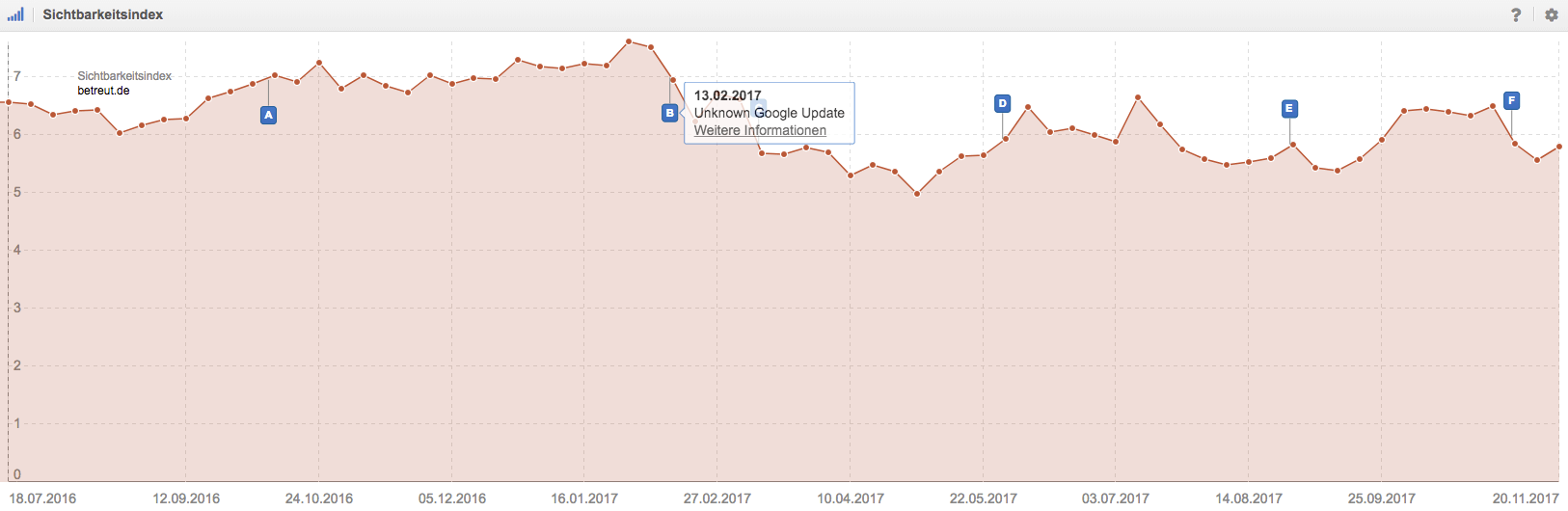

Die häufigen Google Quality Updates der letzten 12 Monate begannen im November 2016 und wiederholten sich seitdem zunächst alle drei Monate (Februar, Mai und August 2017). Seitdem hat sich die Frequenz noch einmal erhöht, sodass einige Beobachter bis zu drei separate Updates im September und zwei im Oktober verzeichnen. Zusätzlich ereignete sich im März 2017 das sogenannte Fred Update, das von einigen SEOs auch den Quality Updates zugerechnet wird.

Auffällig ist, dass einige Seiten bei einem der Updates verlieren, nur um dann beim nächsten Update die verlorene Sichtbarkeit zurückzuerlangen (oder andersherum). Ein gutes Beispiel dafür ist die Seite betreut.de:

Abbildung 3: Einfluss der Quality-Updates auf den Sichtbarkeitsverlauf. Quelle: SISTRIX

Während die Ziele der Panda und Penguin Updates noch ziemlich klar benannt werden konnten, sieht die Sache bei den Quality Updates etwas komplizierter aus. Es existieren verschiedene Theorien zu den konkreten Zielen, die wir hier kurz vorstellen möchten.

Sicher ist, dass die Quality Updates Änderungen der Bewertung der inhaltlichen Qualität einzelner Seiten durch Google darstellen. Doch was genau versteht Google unter „inhaltlicher Qualität“? Um diese Frage zu beantworten hilft ein Blick in die Quality Rater Guidelines von Google.

Diese Guidelines sind ein Leitfaden zur manuellen Qualitätsbewertung, an dem sich die Google Quality Raters orientieren. Diese Quality Raters bewerten Webseiten manuell, um so die Ergebnisse des Rankingalgorithmus zu überprüfen.

Die Bewertungen erfolgen immer unter Berücksichtigung des Zweckes einer Webseite. Die grundlegenden Bewertungskriterien sind hierbei Expertise, Authoritativness und Trustworthiness (E-A-T). Es wird also geprüft, ob die Inhalte einer Seite Expertenwissen widerspiegeln, ob die Seite für ihre Nische eine Autorität darstellt und wie vertrauenswürdig die Webseite ist.

Anzeichen für ein hohes Maß an E-A-T sind zum Beispiel nachvollziehbare Quellenangaben, die Identität der Autoren, ein aussagekräftiges Impressum, sowie externe Bewertungen und die allgemeine Reputation einer Seite.

Neben den E-A-T-Faktoren, die Anzeichen für eine hohe Qualität darstellen, gibt es auch Punkte, die Google in den Guidelines als Zeichen für eine niedrige Qualität anführt. Hierzu gehören etwa zu viele, störende oder irreführende Anzeigen, ein geringer Umfang des Hauptinhaltes, fehlende Informationen zu den Seitenbetreibern oder faktisch falsche Aussagen.

Ein weiterer wichtiger Abschnitt der Quality Rater Guidelines betrifft die Intention der suchenden Nutzer. Hierbei wird bewertet, inwieweit eine Seite das Informationsbedürfnis eines Suchenden befriedigt.

Die Bewertung der Suchintention ist besonders bei kurzen Suchbegriffen (Short-Head-Keywords) oft schwierig. So ist unklar, ob ein Nutzer, der den Suchbegriff „iPhone“ bei Google eingibt, Informationen zum iPhone, Kaufangebote oder Bewertungen sucht.

Bei sogenannten Long-Tail-Keywords ist die Intention klarer (etwa „iPhone kaufen“, „iPhone Bewertungen“, iPhone Preisvergleich“).

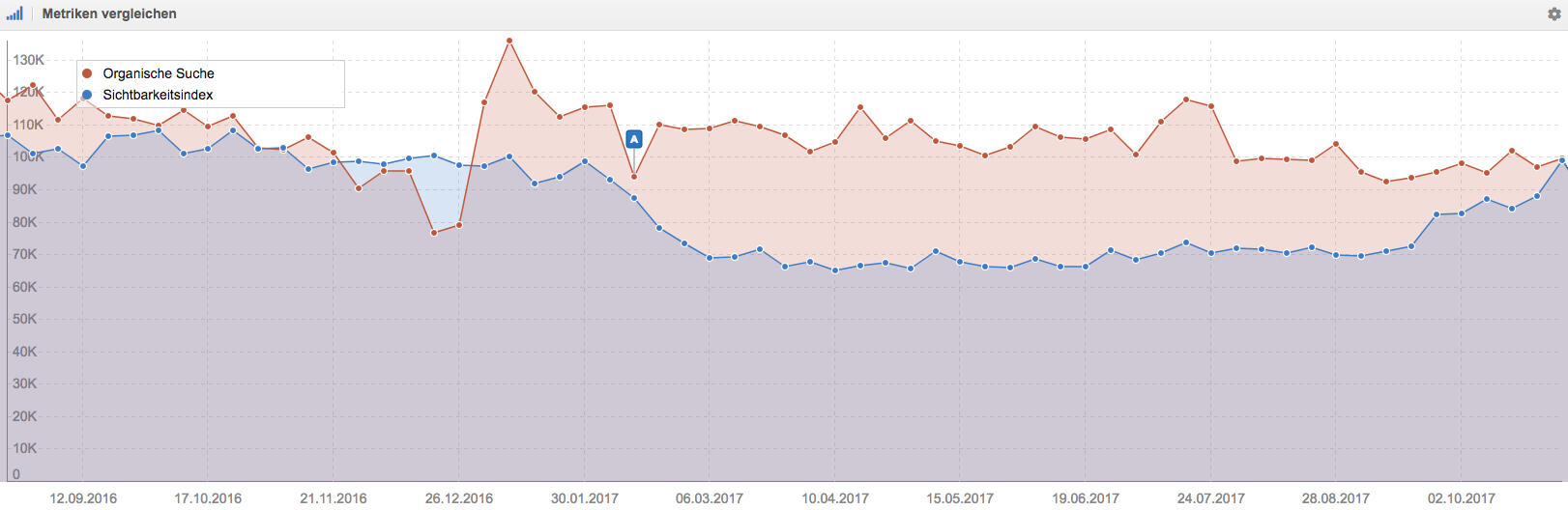

Bei unseren Analysen von durch die Quality Updates betroffenen Seiten ist uns häufig aufgefallen, dass Domains Rankings für Short-Head-Keywords verlieren und gleichzeitig welche für Long-Tail-Keywords gewinnen. Das führt teilweise dazu, dass Webseiten trotz eines Abfalls der Sichtbarkeit ihren organischen Traffic und die generierten Umsätze steigern konnten, da die Nutzer über Long-Tail-Keywords oft besser konvertieren.

Einige der Domains, die im Laufe der Updates stark an Sichtbarkeit verloren haben, setzen zur Monetarisierung ihrer Nutzer vorrangig auf Anzeigen. Grundsätzlich stellt die Einbindung von Anzeigen für ein gutes Ranking bei Google kein Problem dar, jedoch müssen hier einige Punkte beachtet werden:

Während einige der Verliererdomains klar gegen diese Richtlinien verstoßen haben, gab es andere Domains, die durch die Quality Updates an Sichtbarkeit verloren haben und überhaupt keine Anzeigen einbinden. Somit mag es zwar sein, dass Anzeigen einen Faktor der Updates darstellen, es können aber nicht alle Auswirkungen damit erklärt werden.

Die Nutzbarkeit einer Seite bestimmt selbstverständlich auch die Qualität einer Webseite. Die besten Inhalte bringen den Nutzern nichts, wenn sie aufgrund einer unlogischen Navigation nicht gefunden werden oder wenn interaktive Elemente nicht funktionieren.

Weitere Einschränkungen der Usability können sich durch eine fehlerhafte Programmierung, eine unübersichtliche Farbgestaltung oder hohe Ladezeiten ergeben.

Inwieweit Google diese Faktoren direkt bewertet oder sie durch die Analyse von Nutzersignalen indirekt in das Ranking einfließen lässt ist nicht bekannt, aber die Nutzbarkeit einer Seite spielt auch in den Quality Rater Guidelines eine wichtige Rolle.

Ein eng mit der Nutzbarkeit im Zusammenhang stehender Faktor ist die Gestaltung der Seitentemplates. Ein übersichtlicher Aufbau einer Seite verbessert das Nutzererlebnis, während ein unübersichtlicher oder chaotischer Aufbau die Nutzbarkeit stark einschränkt.

Ein wichtiger Faktor hierbei ist die Platzierung von Inhalten Above-the-Fold, also im ohne Scrollen sichtbaren Bereich der Seite. Die für den Hauptzweck einer Seite wichtigsten Elemente sollten hier angeordnet sein, während Anzeigen oder unwichtige Elemente Below-the-Fold platziert werden sollten.

Google hat den Seitenaufbau bereits Anfang 2012 mit dem Page Layout Update zum Ziel eines Algorithmusupdates gemacht, jedoch ist durchaus möglich, dass auch bei den aktuellen Quality Updates das Layout eine Rolle spielt.

Die für Webseitenbetreiber wichtigsten Fragen sind natürlich, wie sie sich vor den negativen Auswirkungen der Quality Updates schützen können. Das betrifft sowohl Seiten, die bereits an Sichtbarkeit eingebüßt haben, als auch alle anderen, da nicht davon auszugehen ist, dass die Updates von nun an weniger werden.

Angesichts der langen Liste an möglichen Ursachen für die Updates können hier keine konkreten, allgemeinen Empfehlungen ausgesprochen werden, jedoch wollen wir einen Prozess vorstellen, mithilfe dessen die richtigen Erkenntnisse erlangt werden können.

Zunächst muss eine tiefgreifende Analyse der beobachteten Veränderungen erfolgen. Eine reine Betrachtung des Sichtbarkeitsverlaufes gibt hier nur begrenzt Aufschluss. Wichtiger ist die Beantwortung der folgenden Fragen:

Bei dieser Analyse helfen verschiedene SEO-Tools wie zum Beispiel Sistrix, Searchmetrics oder auch die Google Search Console.

Bei dieser Analyse sollte auch ein Blick auf die Trafficentwicklung nicht fehlen. So kann festgestellt werden, ob es sich bei den verlorenen Rankings auch um tatsächlich relevante Suchbegriffe gehandelt hat.

Abbildung 4: Die Sichtbarkeit fällt, der organische Traffic bleibt stabil. Quelle: SISTRIX

Nicht jede Veränderung der Sichtbarkeit ist Resultat eines Google Updates. Daher muss die Analyse auch die möglichen Einflüsse externer Faktoren berücksichtigen. Unter externen Faktoren verstehe ich in diesem Zusammenhang folgende Punkte:

Um diese Faktoren zu bestimmen ist eine gute Kommunikation innerhalb des Unternehmens notwendig. Nur so wissen alle Beteiligten, was welche Abteilung eventuell geändert hat und welchen Einfluss dies haben kann. Um auszuschließen, dass eventuelle Rankingverluste das Resultat einer manuellen Abstrafung durch Google sind genügt ein Blick in die Google Search Console.

Nachdem die Rankingveränderungen lokalisiert und der Einfluss externer Faktoren bestimmt wurde kann eine Analyse der genauen Ursachen erfolgen. Hierzu ist es unerlässlich, mögliche Qualitätsmängel der eigenen Seite ehrlich zu bestimmen. Bei diesem Prozess kann es von Vorteil sein, einen externen Dienstleister zur Hilfe zu nehmen, da dieser oft einen weniger emotionalen Blick auf eine Domain einnehmen kann.

Um problematische URLs oder Webseitenbereiche zu identifizieren sollte zunächst ein kompletter Crawl der Webseite durchgeführt werden, um einen Überblick über die vorhandenen Inhalte zu gewinnen. Hierzu können je nach Seitengröße verschiedene Crawler zum Einsatz kommen. Wir verwenden bei uns in der Agentur hauptsächlich den Screaming Frog oder DeepCrawl, Audisto, Botify oder andere Tools können aber auch sehr hilfreich sein.

Die durch den Crawl erstellte Liste aller URLs muss nun in einem nächsten Schritt mit weiteren Daten angereichert werden. Hierzu gehören Trafficdaten aus Google Analytics oder einem anderen Analysetool, Rankingdaten aus der Search Console, Sistrix oder Searchmetrics, sowie Daten zum Nutzerverhalten (etwa Absprungraten, Time-on-Site, Conversion Rate).

Hierdurch sollte es möglich sein, die problematischen Seiten zu identifizieren. Diese werden im nächsten Schritt einer genaueren Analyse der inhaltlichen Qualität unterzogen.

Zur Identifikation möglicher Qualitätsprobleme empfiehlt es sich, die einzelnen Punkte der Quality Rater Guidelines einzeln zu überprüfen. Bei der Bewertung einzelner Aspekte kann auch ein Blick auf die Konkurrenz in den SERPs helfen:

Sollten bei dieser Analyse Qualitätsprobleme identifiziert werden, muss nun bestimmt werden, wie diese am besten beseitigt werden können.

Grundsätzlich existieren zwei Möglichkeiten, Qualitätsprobleme zu beseitigen:

Welcher Ansatz der richtige ist, muss individuell bestimmt werden. Dabei sollten folgende Überlegungen in die Abwägung mit einfließen:

Am Ende dieser Überlegungen sollte für jede URL eine klare Handlungsanweisung stehen. In der einfachsten Form bestehen folgende drei Möglichkeiten:

In der Regel wird eine ehrliche Analyse der inhaltlichen Schwächen der eigenen Seite die Identifikation verschiedener Verbesserungspotenziale zur Folge haben. Diese Potenziale zu nutzen erfordert oft große Anstrengungen, kann aber zu dauerhaften Verbesserungen führen, die sich nicht nur auf den Bereich SEO auswirken.

So profitieren von einer verbesserten Nutzbarkeit alle Besucher der Seite, egal über welchen Kanal sie auf die Seite gekommen sind. Eine Steigerung der Conversion-Rate lässt die Umsätze über SEO, SEA, Social und weitere Kanäle wachsen. Und zu guter Letzt zahlt eine Erhöhung der inhaltlichen Qualität positiv auf die gesamte Marke ein.

So können die Quality Updates von Google einen Anstoß dazu liefern, als Betreiber seine eigene Webseite besser zu machen. Hiervon profitieren Unternehmen, Nutzer und auch die Suchmaschinen, da sie qualitativ hochwertige Inhalte ausspielen können und so ihre Nutzer befriedigen.

Ich denke, dass diese regelmäßigen Updates langfristig auch die Arbeit von Suchmaschinenoptimierern verbessern werden, weil die zunehmende Wichtigkeit des Rankingfaktors Qualität es den Linkspammern, Cloakern und Scrapern immer schwieriger machen wird, den Rankingalgorithmus zu überlisten.

Somit wird in der Suchmaschinenoptimierung der Fokus immer weiter dahin verschoben, inhaltlich wertvolle Webseiten zu erstellen, die technisch sauber programmiert und ausgezeichnet sind, anstatt irgendwelche Lücken im Rankingalgorithmus auszunutzen. Das macht die Arbeit für SEOs nicht einfacher, sorgt aber dafür, dass wir für unsere Kunden, Arbeitgeber, oder für unsere eigenen Projekte nachhaltige Verbesserungen und richtige Optimierungen erreichen.

Die Google Quality Updates beschäftigen nicht nur uns bei The Reach Group, sondern werden in der SEO-Szene in Deutschland und international stark diskutiert. Hier sind einige Quellen, bei denen Ihr Euch weiter dazu informieren könnt:

Seid Ihr von den Quality Updates betroffen? Habt Ihr Theorien zu den Ursachen? Über Kommentare und Anmerkungen freue ich mich immer sehr!